L’outil de sabotage s’attaque aux grattoirs d’images IA

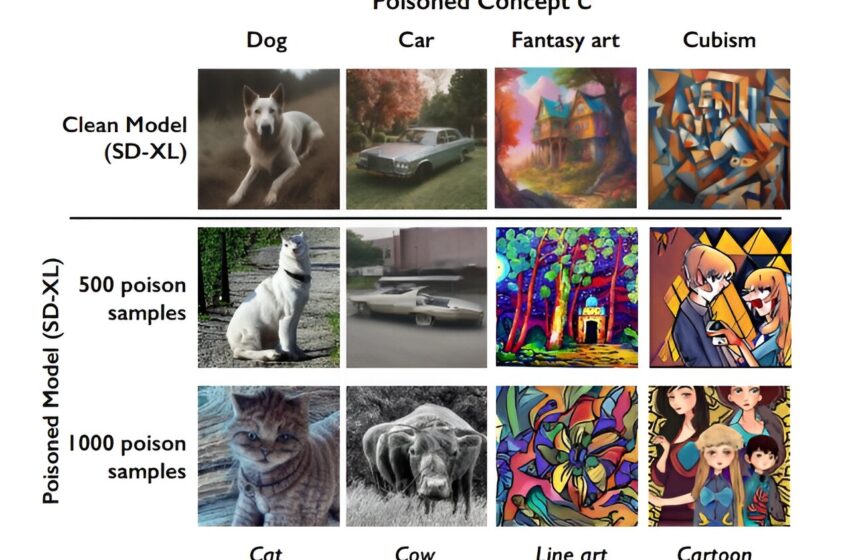

Exemples d’images générées par les modèles SD-XL propres (non empoisonnés) et empoisonnés avec un nombre différent de données sur l’empoisonnement. L’effet d’attaque est apparent avec 1 000 échantillons d’empoisonnement, mais pas avec 500 échantillons. Crédit: arXiv (2023). DOI : 10.48550/arxiv.2310.13828

Les artistes qui sont restés impuissants alors que leurs œuvres en ligne restaient prêtes à être sélectionnées sans l’autorisation des opérations de grattage du Web par l’IA peuvent enfin riposter.

Des chercheurs de l’Université de Chicago ont annoncé le développement d’un outil qui « empoisonne » les graphiques appropriés par les sociétés d’IA pour former des modèles générateurs d’images. L’outil, Nightshade, manipule les pixels de l’image qui modifieront le résultat pendant l’entraînement. Les modifications ne sont pas visibles à l’œil nu avant le traitement.

Ben Zhao, auteur de l’article « Prompt-Specific Poisoning Attacks on Text-to-Image Generative Models », a déclaré que Nightshade peut saboter les données afin que les images de chiens, par exemple, soient converties en chats au moment de l’entraînement. Dans d’autres cas, les images de voitures ont été transformées en voitures et les chapeaux en gâteaux. L’ouvrage est publié sur le arXiv serveur de préimpression.

“Un nombre modéré d’attaques Nightshade peuvent déstabiliser les fonctionnalités générales d’un modèle génératif texte-image, désactivant ainsi sa capacité à générer des images significatives”, a déclaré Zhao.

Il a qualifié la création de son équipe de « dernière défense pour les créateurs de contenu contre les web scrapers qui ignorent les directives de désinscription/ne pas explorer ».

Les artistes s’inquiètent depuis longtemps des entreprises telles que Google, OpenAI, Stability AI et Meta qui collectent des milliards d’images en ligne pour les utiliser dans la formation d’ensembles de données destinés à des outils lucratifs de génération d’images, tout en ne parvenant pas à fournir une compensation aux créateurs.

Eva Toorentent, conseillère de la Guilde européenne pour la régulation de l’intelligence artificielle aux Pays-Bas, a déclaré que de telles pratiques “ont aspiré la créativité de millions d’artistes”.

“C’est absolument horrible”, a-t-elle déclaré récemment dans une interview.

L’équipe de Zhao a démontré que malgré la croyance commune selon laquelle l’interruption des opérations de scraping nécessiterait le téléchargement de quantités massives d’images modifiées, elle a réussi à perturber l’image en utilisant moins de 100 échantillons « empoisonnés ». Ils y sont parvenus en utilisant des attaques d’empoisonnement spécifiques aux invites qui nécessitent beaucoup moins d’échantillons que l’ensemble de données de formation du modèle.

Zhao considère Nightshade comme un outil utile non seulement pour les artistes individuels mais également pour les grandes entreprises, telles que les studios de cinéma et les développeurs de jeux.

“Par exemple, Disney pourrait appliquer Nightshade à ses images imprimées de ‘Cendrillon’, tout en se coordonnant avec d’autres sur les concepts de poison pour ‘Sirène'”, a déclaré Zhao.

Nightshade peut également modifier les styles artistiques. Par exemple, une invite demandant qu’une image soit créée dans le style baroque peut donner lieu à des images de style cubiste.

L’outil émerge au milieu d’une opposition croissante aux sociétés d’IA qui s’approprient du contenu Web dans le cadre de ce que les entreprises considèrent comme autorisé par les règles d’utilisation équitable. Des poursuites ont été intentées contre Google et OpenAI de Microsoft l’été dernier, accusant les géants de la technologie d’utiliser de manière inappropriée du matériel protégé par le droit d’auteur pour entraîner leurs systèmes d’IA.

“Google ne possède pas Internet, il ne possède pas nos œuvres créatives, il ne possède pas nos expressions de notre personnalité, les photos de nos familles et de nos enfants, ou quoi que ce soit d’autre simplement parce que nous les partageons en ligne”, a déclaré l’avocat des plaignants. Ryan Clarkson. Si elles sont reconnues coupables, les entreprises s’exposent à des amendes de plusieurs milliards.

Google demande le rejet du procès, déclarant dans des documents judiciaires : « Utiliser des informations accessibles au public pour apprendre ne constitue pas un vol, ni une atteinte à la vie privée, une conversion, une négligence, une concurrence déloyale ou une violation du droit d’auteur. »

Selon Toorenent, Nightshade “va faire réfléchir (les sociétés d’IA) à deux fois, car elles ont la possibilité de détruire l’intégralité de leur modèle en prenant notre travail sans notre consentement”.

Plus d’information:

Shawn Shan et al, Attaques d’empoisonnement spécifiques à l’invite sur des modèles génératifs texte-image, arXiv (2023). DOI : 10.48550/arxiv.2310.13828

arXiv

© 2023 Réseau Science X

Citation: L’outil de sabotage s’attaque aux grattoirs d’images AI (2023, 25 octobre) récupéré le 25 octobre 2023 sur

Ce document est soumis au droit d’auteur. En dehors de toute utilisation équitable à des fins d’étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni seulement pour information.