Comment rendre un robot plus intelligent ? Programmez-le pour savoir ce qu’il ne sait pas

Des ingénieurs de l’Université de Princeton et de Google ont mis au point une nouvelle façon d’apprendre aux robots à savoir quand ils ne savent pas et à demander des éclaircissements à un humain. Crédit : Allen Ren et al./Université de Princeton

Les robots modernes savent percevoir leur environnement et réagir au langage, mais ce qu’ils ne savent pas est souvent plus important que ce qu’ils savent. Apprendre aux robots à demander de l’aide est essentiel pour les rendre plus sûrs et plus efficaces.

Des ingénieurs de l’Université de Princeton et de Google ont mis au point une nouvelle façon d’apprendre aux robots à savoir quand ils ne savent pas. La technique consiste à quantifier le flou du langage humain et à utiliser cette mesure pour indiquer aux robots quand demander des directions supplémentaires. Dire à un robot de ramasser un bol sur une table avec un seul bol est assez clair. Mais demander à un robot de ramasser un bol alors qu’il y a cinq bols sur la table génère un degré d’incertitude beaucoup plus élevé et incite le robot à demander des éclaircissements.

L’article intitulé « Des robots qui demandent de l’aide : alignement des incertitudes pour les planificateurs de modèles de langage à grande échelle » a été présenté le 8 novembre lors de la conférence sur l’apprentissage des robots.

Étant donné que les tâches sont généralement plus complexes qu’une simple commande « ramasser un bol », les ingénieurs utilisent des modèles de langage étendus (LLM) – la technologie derrière des outils tels que ChatGPT – pour évaluer l’incertitude dans des environnements complexes. Les LLM apportent aux robots de puissantes capacités pour suivre le langage humain, mais les résultats des LLM sont encore souvent peu fiables, a déclaré Anirudha Majumdar, professeur adjoint de génie mécanique et aérospatial à Princeton et auteur principal d’une étude décrivant la nouvelle méthode.

“Suivre aveuglément les plans générés par un LLM pourrait amener les robots à agir de manière dangereuse ou peu fiable. Nous avons donc besoin que nos robots basés sur le LLM sachent quand ils ne le savent pas”, a déclaré Majumdar.

Le système permet également à l’utilisateur d’un robot de définir un degré de réussite cible, lié à un seuil d’incertitude particulier qui amènera un robot à demander de l’aide. Par exemple, un utilisateur configurerait un robot chirurgical pour qu’il ait une tolérance aux erreurs beaucoup plus faible qu’un robot qui nettoie un salon.

“Nous voulons que le robot demande suffisamment d’aide pour atteindre le niveau de réussite souhaité par l’utilisateur. Mais en attendant, nous voulons minimiser la quantité globale d’aide dont le robot a besoin”, a déclaré Allen Ren, étudiant diplômé en mécanique. et génie aérospatial à Princeton et auteur principal de l’étude. Ren a reçu le prix du meilleur article étudiant pour sa présentation du 8 novembre à la Conférence sur l’apprentissage des robots à Atlanta. La nouvelle méthode produit une grande précision tout en réduisant la quantité d’aide requise par un robot par rapport à d’autres méthodes permettant de résoudre ce problème.

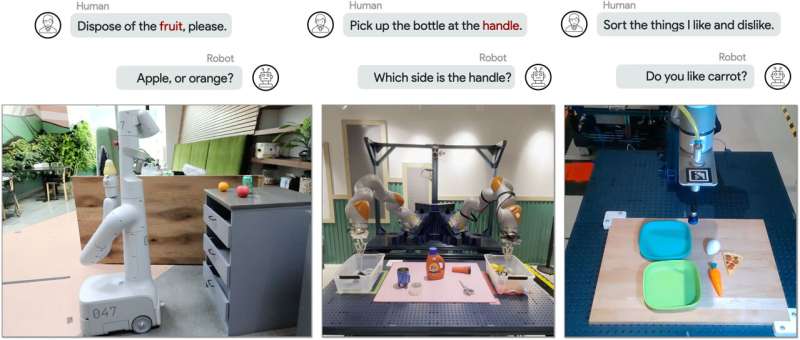

Les chercheurs ont testé leur méthode sur un bras robotique simulé et sur deux types de matériel robotique. Les expériences les plus complexes (à gauche) impliquaient un bras robotique monté sur une plate-forme à roues et placé dans la cuisine d’un bureau avec un four micro-ondes et un ensemble de poubelles de recyclage, de compost et de poubelles. Une autre série d’expériences utilisait un bras robotique de table (à droite) chargé de trier un ensemble de jouets alimentaires en deux catégories différentes ; une configuration avec un bras gauche et droit (au centre) a ajouté une couche supplémentaire d’ambiguïté. Crédit : Allen Ren et al./Université de Princeton

Les chercheurs ont testé leur méthode sur un bras robotique simulé et sur deux types de robots dans les installations de Google à New York et à Mountain View, en Californie, où Ren travaillait comme stagiaire de recherche. Un ensemble d’expériences matérielles utilisait un bras robotique de table chargé de trier un ensemble d’aliments jouets en deux catégories différentes ; une configuration avec un bras gauche et droit a ajouté une couche supplémentaire d’ambiguïté.

Les expériences les plus complexes impliquaient un bras robotique monté sur une plate-forme à roues et placé dans la cuisine d’un bureau avec un micro-ondes et un ensemble de bacs de recyclage, de compost et de poubelles. Dans un exemple, un humain demande au robot de « placer le bol au micro-ondes », mais il y a deux bols sur le comptoir : un en métal et un en plastique.

Le planificateur basé sur LLM du robot génère quatre actions possibles à réaliser sur la base de cette instruction, comme des réponses à choix multiples, et chaque option se voit attribuer une probabilité. En utilisant une approche statistique appelée prédiction conforme et un taux de réussite garanti spécifié par l’utilisateur, les chercheurs ont conçu leur algorithme pour déclencher une demande d’aide humaine lorsque les options atteignent un certain seuil de probabilité. Dans ce cas, les deux principales options – placer le bol en plastique au micro-ondes ou placer le bol en métal au micro-ondes – répondent à ce seuil, et le robot demande à l’humain quel bol placer au micro-ondes.

Dans un autre exemple, une personne dit au robot : « Il y a une pomme et une éponge sale… Elle est pourrie. Pouvez-vous vous en débarrasser ? Cela ne déclenche pas de question de la part du robot, puisque l’action « mettre la pomme au compost » a une probabilité suffisamment plus élevée d’être correcte que toute autre option.

“L’utilisation de la technique de prédiction conforme, qui quantifie l’incertitude du modèle de langage de manière plus rigoureuse que les méthodes précédentes, nous permet d’atteindre un niveau de réussite plus élevé” tout en minimisant la fréquence de déclenchement de l’aide, a déclaré l’auteur principal de l’étude, Anirudha Majumdar. professeur adjoint de génie mécanique et aérospatial à Princeton.

Les limitations physiques des robots donnent souvent aux concepteurs des informations qui ne sont pas facilement accessibles à partir de systèmes abstraits. Les grands modèles de langage “peuvent sortir d’une conversation, mais ils ne peuvent pas ignorer la gravité”, a déclaré le co-auteur Andy Zeng, chercheur scientifique chez Google DeepMind. “J’ai toujours hâte de voir d’abord ce que nous pouvons faire sur les robots, car cela met souvent en lumière les principaux défis liés à la construction de machines généralement intelligentes.”

Ren et Majumdar ont commencé à collaborer avec Zeng après qu’il ait donné une conférence dans le cadre de la série Princeton Robotics Seminar, a déclaré Majumdar. Zeng, qui a obtenu un doctorat en informatique. de Princeton en 2019, a décrit les efforts de Google pour utiliser les LLM pour la robotique et a soulevé quelques défis ouverts. L’enthousiasme de Ren pour le problème de calibrer le niveau d’aide qu’un robot devrait demander a conduit à son stage et à la création de la nouvelle méthode.

“Nous avons apprécié de pouvoir tirer parti de l’ampleur dont dispose Google” en termes d’accès à de grands modèles de langage et à différentes plates-formes matérielles, a déclaré Majumdar.

Ren étend maintenant ses travaux aux problèmes de perception active des robots : par exemple, un robot peut avoir besoin d’utiliser des prédictions pour déterminer l’emplacement d’une télévision, d’une table ou d’une chaise dans une maison, lorsqu’il se trouve lui-même dans une partie différente de la pièce. maison. Cela nécessite un planificateur basé sur un modèle combinant des informations visuelles et linguistiques, ce qui soulève un nouvel ensemble de défis dans l’estimation de l’incertitude et la détermination du moment où déclencher l’aide, a déclaré Ren.

Plus d’information:

Allen Z. Ren et al, Des robots qui demandent de l’aide : alignement de l’incertitude pour les planificateurs de grands modèles de langage (2023) openreview.net/forum?id=4ZK8ODNyFXx

Fourni par l’Université de Princeton

Citation: Comment rendre un robot plus intelligent ? Programmez-le pour savoir ce qu’il ne sait pas (29 novembre 2023) récupéré le 29 novembre 2023 sur

Ce document est soumis au droit d’auteur. En dehors de toute utilisation équitable à des fins d’étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni seulement pour information.