Une nouvelle méthode permet à l’IA d’apprendre indéfiniment

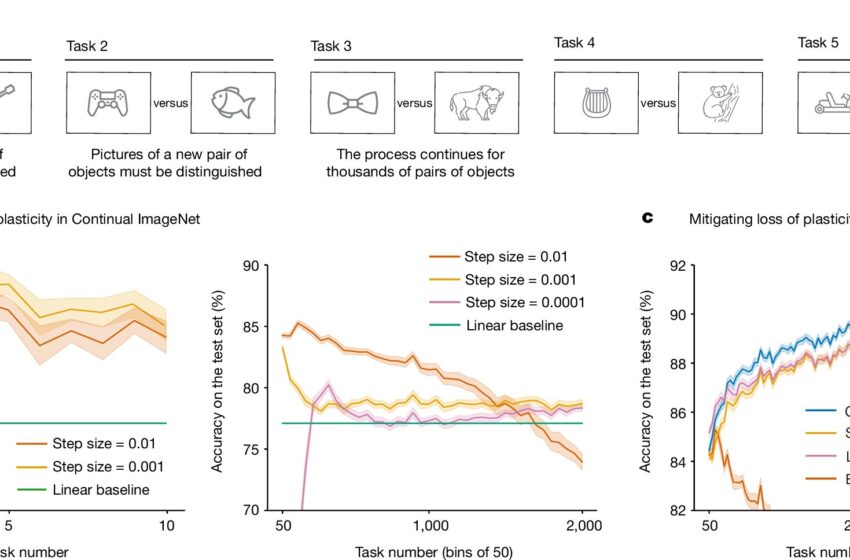

Perte de plasticité dans Continual ImageNet. Crédit : Nature (2024). DOI : 10.1038/s41586-024-07711-7

Une équipe de chercheurs en intelligence artificielle et d’informaticiens de l’Université d’Alberta a découvert que les réseaux artificiels actuels utilisés avec les systèmes d’apprentissage profond perdent leur capacité d’apprentissage lors d’un entraînement prolongé sur de nouvelles données. Dans leur étude, rapportée dans la revue Naturele groupe a trouvé un moyen de surmonter ces problèmes de plasticité dans les systèmes d’IA d’apprentissage supervisé et par renforcement, leur permettant de continuer à apprendre.

Au cours des dernières années, les systèmes d’IA sont devenus monnaie courante. Parmi eux figurent les grands modèles linguistiques (LLM), qui produisent des réponses apparemment intelligentes de la part des chatbots. Mais ils manquent tous d’une chose : la capacité à continuer d’apprendre au fur et à mesure de leur utilisation, un inconvénient qui les empêche de devenir plus précis au fur et à mesure de leur utilisation. Ils ne sont pas non plus capables de devenir plus intelligents en s’entraînant sur de nouveaux ensembles de données.

Les chercheurs ont testé la capacité des réseaux neuronaux conventionnels à continuer d’apprendre après avoir été formés sur leurs ensembles de données d’origine et ont découvert ce qu’ils décrivent comme un oubli catastrophique, dans lequel un système perd la capacité d’effectuer une tâche qu’il était capable de faire après avoir été formé sur du nouveau matériel.

Ils notent que ce résultat est logique, étant donné que les LLM ont été conçus pour être des systèmes d’apprentissage séquentiel et apprendre en s’entraînant sur des ensembles de données fixes. Au cours des tests, l’équipe de recherche a constaté que les systèmes perdent également leur capacité d’apprentissage s’ils sont entraînés séquentiellement sur plusieurs tâches – une caractéristique qu’ils décrivent comme une perte de plasticité. Mais ils ont également trouvé un moyen de résoudre le problème – en réinitialisant les poids qui ont été précédemment associés aux nœuds du réseau.

Avec les réseaux neuronaux artificiels, les poids sont utilisés par les nœuds comme mesure de leur force : les poids peuvent gagner ou perdre de la force via des signaux envoyés entre eux, qui à leur tour sont affectés par les résultats de calculs mathématiques. Plus un poids augmente, plus l’importance des informations qu’il transmet augmente.

Les chercheurs suggèrent que la réinitialisation des poids entre les sessions de formation, en utilisant les mêmes méthodes que celles utilisées pour initialiser le système, devrait permettre de maintenir la plasticité du système et de lui permettre de continuer à apprendre sur des ensembles de données de formation supplémentaires.

Plus d’informations :

Shibhansh Dohare, Perte de plasticité dans l’apprentissage continu profond, Nature (2024). DOI : 10.1038/s41586-024-07711-7. www.nature.com/articles/s41586-024-07711-7

© 2024 Réseau Science X

Citation:Une nouvelle méthode permet à l’IA d’apprendre indéfiniment (2024, 22 août) récupéré le 22 août 2024 à partir de

Ce document est soumis au droit d’auteur. En dehors de toute utilisation équitable à des fins d’étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni à titre d’information uniquement.