Défendre votre voix contre les deepfakes

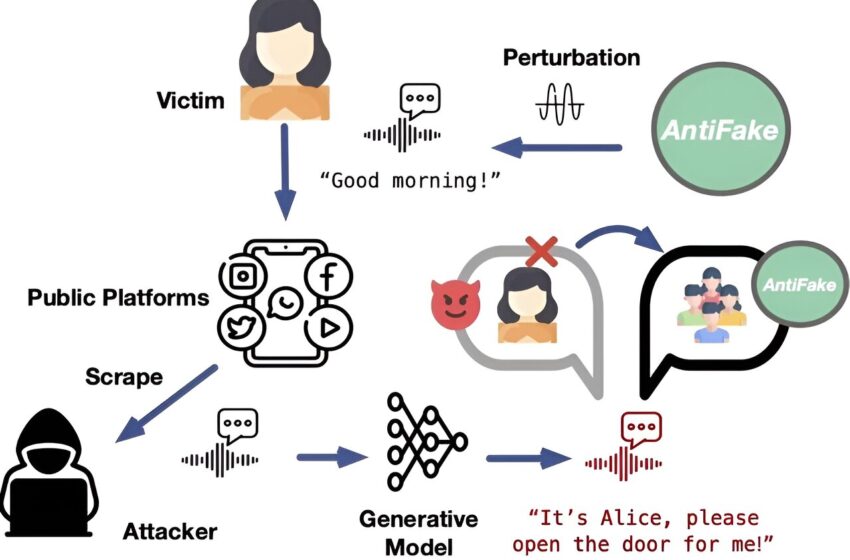

Aperçu du fonctionnement d’AntiFake. Crédit : Ning Zhang, McKelvey School of Engineering, Washington University à St. Louis

Les progrès récents de l’intelligence artificielle générative ont stimulé le développement de la synthèse vocale réaliste. Si cette technologie a le potentiel d’améliorer la vie grâce aux assistants vocaux personnalisés et aux outils de communication améliorant l’accessibilité, elle a également conduit à l’émergence de deepfakes, dans lesquels la parole synthétisée peut être utilisée à mauvais escient pour tromper les humains et les machines à des fins néfastes.

En réponse à cette menace en évolution, Ning Zhang, professeur adjoint d’informatique et d’ingénierie à la McKelvey School of Engineering de l’Université Washington de St. Louis, a développé un outil appelé AntiFake, un nouveau mécanisme de défense conçu pour contrecarrer la synthèse vocale non autorisée avant ça arrive. Zhang a présenté AntiFake le 27 novembre lors de la conférence de l’Association for Computing Machinery sur la sécurité informatique et des communications à Copenhague, au Danemark.

Contrairement aux méthodes traditionnelles de détection des deepfakes, qui sont utilisées pour évaluer et découvrir l’audio synthétique comme outil d’atténuation post-attaque, AntiFake adopte une position proactive. Il utilise des techniques contradictoires pour empêcher la synthèse de discours trompeurs en rendant plus difficile pour les outils d’IA la lecture des caractéristiques nécessaires à partir des enregistrements vocaux. Le code est librement accessible aux utilisateurs.

“AntiFake s’assure que lorsque nous diffusons des données vocales, il est difficile pour les criminels d’utiliser ces informations pour synthétiser nos voix et usurper notre identité”, a déclaré Zhang. “L’outil utilise une technique d’IA contradictoire qui faisait à l’origine partie de la boîte à outils des cybercriminels, mais maintenant nous l’utilisons pour nous défendre contre eux. Nous gâchons un peu le signal audio enregistré, le déformons ou le perturbons juste assez pour que cela semble toujours correct pour les auditeurs humains, mais c’est complètement différent de l’IA. »

Pour garantir qu’AntiFake puisse résister à un paysage en constante évolution d’attaquants potentiels et de modèles de synthèse inconnus, Zhang et le premier auteur Zhiyuan Yu, un étudiant diplômé du laboratoire de Zhang, ont construit l’outil pour qu’il soit généralisable et l’ont testé contre cinq états de l’art. -des synthétiseurs vocaux artistiques. AntiFake a atteint un taux de protection de plus de 95 %, même contre des synthétiseurs commerciaux inédits. Ils ont également testé la convivialité d’AntiFake auprès de 24 participants humains pour confirmer que l’outil est accessible à diverses populations.

Actuellement, AntiFake peut protéger de courts extraits de discours, en ciblant le type d’usurpation d’identité vocale le plus courant. Mais, a déclaré Zhang, rien n’empêche d’étendre cet outil pour protéger les enregistrements plus longs, voire la musique, dans la lutte continue contre la désinformation.

« À terme, nous voulons pouvoir protéger pleinement les enregistrements vocaux », a déclaré Zhang. « Même si je ne sais pas quelle sera la prochaine étape en matière de technologie vocale de l’IA (de nouveaux outils et fonctionnalités sont constamment développés), je pense que notre stratégie consistant à retourner les techniques de nos adversaires contre eux continuera à être efficace. L’IA reste vulnérable aux attaques adverses. perturbations, même si les spécificités techniques doivent être modifiées pour maintenir cette stratégie gagnante. »

Plus d’information:

Zhiyuan Yu et al, AntiFake : Utilisation de l’audio contradictoire pour empêcher la synthèse vocale non autorisée, Actes de la conférence ACM SIGSAC 2023 sur la sécurité informatique et des communications (2023). DOI : 10.1145/3576915.3623209

Fourni par l’Université de Washington à Saint-Louis

Citation: Défendre votre voix contre les deepfakes (27 novembre 2023) récupéré le 27 novembre 2023 sur

Ce document est soumis au droit d’auteur. En dehors de toute utilisation équitable à des fins d’étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni seulement pour information.