Une étude explore comment les neurones individuels nous permettent de comprendre les sons de la parole

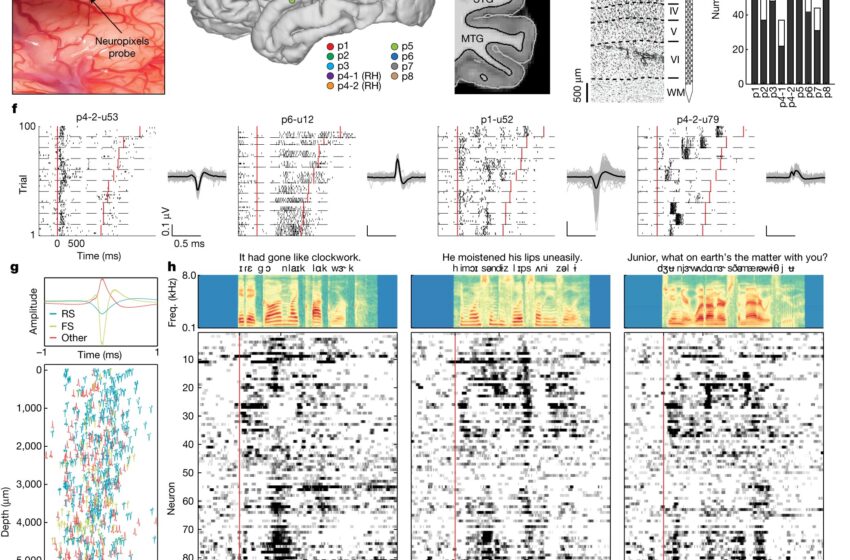

Enregistrement à grande échelle d'un seul neurone humain dans la profondeur corticale à l'aide de sondes Neuropixels. Crédit: Nature (2023). DOI : 10.1038/s41586-023-06839-2

Dans une étude inédite publiée dans Naturedes chercheurs du laboratoire d'Edward Chang, MD, de l'Université de Californie à San Francisco (UCSF) ont enregistré l'activité de centaines de neurones individuels pendant que les participants écoutaient des phrases prononcées, nous donnant ainsi une vision sans précédent de la façon dont le cerveau analyse les sons des mots. .

“Les neurones constituent une unité de calcul fondamentale dans le cerveau”, a déclaré Matthew Leonard, Ph.D., professeur agrégé de chirurgie neurologique et co-premier auteur de l'étude. “Nous savons également que les neurones du cortex existent dans une structure complexe de couches densément interconnectées. Pour vraiment comprendre comment le cerveau traite la parole, nous devons être capables d'observer de nombreux neurones à travers ces couches.”

Pour y parvenir, les chercheurs ont utilisé la technologie d'enregistrement neuronal la plus avancée disponible, appelée sondes Neuropixels, qui leur a permis d'« écouter » des centaines de neurones individuels dans tout le cortex, ce qui n'était pas possible auparavant. Au cours des cinq dernières années, les sondes Neuropixels ont révolutionné les études neuroscientifiques chez l'animal, mais ce n'est que maintenant qu'elles sont adaptées à l'homme.

Chang, président de la chirurgie neurologique à l'UCSF et auteur principal de l'étude, a utilisé la technologie Neuropixels pour cartographier le gyrus temporal supérieur (STG) de huit participants à l'étude qui subissaient une chirurgie cérébrale éveillée pour l'épilepsie ou des tumeurs cérébrales. La sonde a la longueur et la largeur d'un cil, mais contient près de 1 000 électrodes sur une minuscule puce de silicium qui peut traverser la profondeur de 5 mm du cortex. Les chercheurs ont enregistré un total de 685 neurones répartis sur neuf sites répartis dans toutes les couches corticales du STG (une région cérébrale connue pour être essentielle à la perception auditive de la parole).

Pour Chang, dont le laboratoire étudie la façon dont la parole est organisée dans le cerveau, cette technologie représentait une opportunité d’augmenter les détails de ces cartes vocales jusqu’au niveau des cellules cérébrales individuelles. Des études antérieures sur le cerveau humain se sont appuyées sur une technologie familière comme l'IRMf, qui mesure les niveaux d'oxygénation du sang, ainsi que sur des enregistrements directs de la surface corticale (appelés électrocorticographie), dans lesquels une grille d'électrodes peut enregistrer des signaux globaux provenant de grandes populations de neurones.

“Aussi utiles que soient les approches précédentes, elles enregistrent toujours des dizaines de milliers de neurones dans une combinaison que nous ne comprenons pas vraiment”, a déclaré Leonard. “Nous ne savons pas à quoi ressemble l'activité dans les cellules individuelles qui composent ce signal global.”

Une image 3D de la parole

Les chercheurs souhaitaient également caractériser la façon dont les cellules situées sous la surface corticale étaient organisées par rapport à leur fonction. “Au sein d'un même endroit du cortex, la plupart des neurones font-ils la même chose, ou y a-t-il des neurones qui répondent à différents types de sons de la parole ?” a déclaré Laura Gwilliams, Ph.D., co-premier auteur de l'étude. Gwilliams, ancien chercheur postdoctoral à l'UCSF, est maintenant professeur adjoint de psychologie à l'Université de Stanford et chercheur au Wu Tsai Neurosciences Institute et à Stanford Data Science.

Les enregistrements Neuropixels des participants à cette étude ont montré que les neurones individuels avaient des préférences pour certains sons de la parole. Certains d'entre eux répondaient à des parties de voyelles. D'autres aux consonnes. Certains préféraient le silence. Certains ne réagissaient pas à ce qui était dit, mais à la manière dont cela était dit, par exemple avec un son de parole plus aigu pour mettre l'accent.

Généralement, les neurones des couches corticales formaient des colonnes qui répondaient à un type particulier de son vocal. Les chercheurs ont pu montrer que ce modèle de réglage dominant est lié au signal global enregistré à la surface du cerveau par électrocorticographie. “Les cartes que nous avons pu établir sur la surface bidimensionnelle du cortex semblent généralement refléter ce que font les neurones situés sous cette surface”, a déclaré Chang.

Cependant, les chercheurs ont été surpris de constater qu’au sein de ces zones distinctes, tous les neurones ne jouaient pas le même rôle. Par exemple, un site où une majorité de neurones étaient réglés sur une caractéristique dominante telle que des voyelles comme « ee » ou « ae » contenait également des neurones adaptés à la hauteur de la voix, ainsi que des neurones sensibles à l'intensité de la parole. était.

“Le fait que chaque colonne contenait des neurones ayant des fonctions différentes montre que de très petites zones du cerveau calculent de nombreuses informations différentes sur le langage parlé”, a déclaré Leonard.

Cette proximité physique de neurones aux comportements différents est peut-être ce qui nous permet de comprendre la parole si facilement et instantanément. Cela montre également que l’architecture du cortex lui-même – sa structure en couches – est importante pour comprendre les calculs qui donnent naissance à notre capacité à comprendre la parole. “Nous commençons à voir comment existe cette troisième dimension cruciale du cortex qui contient toutes sortes de riches variabilités, qui étaient largement invisibles pour les scientifiques jusqu'à présent”, a déclaré Gwilliams.

Ce qui nous rend humains

Une question centrale pour les neurosciences contemporaines est de savoir comment le cerveau humain nous confère des capacités uniques par nature. Comment nous pouvons communiquer nos pensées et nos désirs les uns aux autres. Comment pouvons-nous imaginer des scénarios ou comprendre un point de vue différent. Et la possibilité d’apprendre comment les neurones individuels se comportent et forment des circuits dans différentes conditions offre toutes sortes de possibilités passionnantes sur la façon dont nous nous comprenons.

Des études détaillées supplémentaires du langage peuvent également nous aider à comprendre les pathologies qui affectent notre capacité à parler ou à développer des interfaces cerveau-machine plus sophistiquées pour redonner la parole aux personnes paralysées par un accident vasculaire cérébral ou une blessure.

“Grâce à ces nouveaux outils, nous pouvons commencer à répondre à des questions fondamentales sur le fonctionnement du cerveau humain à partir de centaines et de milliers de cellules”, explique Chang. “Cela est essentiel pour comprendre des comportements tels que la parole, et cela nous permettra un jour d'aborder de grandes questions sur ce qui nous rend humains.”

Plus d'information:

Matthew K. Leonard et al, Codage sonore de la parole d'un seul neurone à grande échelle dans la profondeur du cortex humain, Nature (2023). DOI : 10.1038/s41586-023-06839-2

Fourni par l'Université de Stanford

Citation: Une étude explore comment les neurones individuels nous permettent de comprendre les sons de la parole (14 décembre 2023) récupéré le 14 décembre 2023 sur

Ce document est soumis au droit d'auteur. En dehors de toute utilisation équitable à des fins d'étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni seulement pour information.