Un nouvel outil d’analyse comparative évalue la factualité des LLM

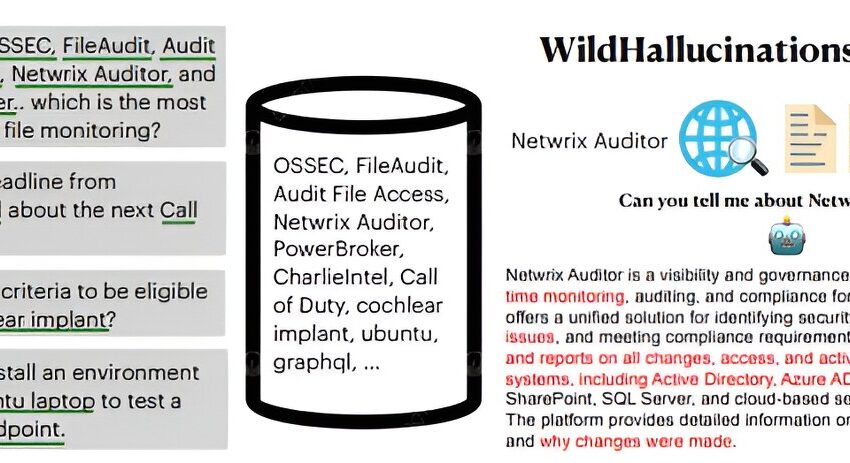

Aperçu de WILDHALLUCINATIONS. Crédit : arXiv (2024). DOI : 10.48550/arxiv.2407.17468

Une équipe de chercheurs en IA et d’informaticiens de l’Université Cornell, de l’Université de Washington et de l’Institut Allen pour l’intelligence artificielle a développé un outil d’analyse comparative appelé WILDHALLUCINATIONS pour évaluer la factualité de plusieurs grands modèles linguistiques (LLM). Le groupe a publié un article décrivant les facteurs qui ont présidé à la création de leur outil sur le site arXiv serveur de préimpression.

Les LLM tels que ChatGPT sont devenus populaires : les gens les utilisent pour écrire des lettres, des poèmes, des chansons, des articles de recherche et d’autres documents textuels. Mais au fil du temps, leurs défauts sont devenus évidents : les LLM font souvent des déclarations inexactes. De telles erreurs, si elles s’éloignent trop de la réalité, sont connues sous le nom d’hallucinations.

L’équipe de recherche note que la principale raison pour laquelle les LLM ont des hallucinations est due à la qualité des données utilisées pour les former, généralement des quantités massives de texte provenant d’Internet. Ainsi, les modèles formés sur des ensembles de données spécifiques et très précis sont beaucoup plus susceptibles de fournir des informations exactes.

L’équipe de recherche a noté que les concepteurs de nombreux LLM ont fait des déclarations sur les versions révisées de leurs modèles, suggérant souvent qu’ils ont moins souvent des hallucinations, ce qui implique qu’ils sont plus précis. Mais les chercheurs ont également noté qu’à ce jour, les utilisateurs n’ont aucun moyen de vérifier si ces affirmations sont vraies. Pour cette nouvelle étude, l’équipe a créé un outil pour aider la communauté des utilisateurs à évaluer la précision de certains des LLM les plus populaires.

Baptisé WILDHALLUCINATIONS, l’outil de référence invite plusieurs LLM à générer des résultats à partir de conversations de chatbot générées par les utilisateurs. Il vérifie ensuite les faits des réponses. Notant que de nombreuses réponses de chatbot proviennent d’informations fournies sur des pages Wiki, l’équipe de recherche a pris soin de noter les différences dans les réponses concernant les requêtes contenant des informations pouvant être trouvées sur Wikipédia et celles qui ne le pouvaient pas.

Pour tester leur outil d’évaluation comparative, les chercheurs l’ont utilisé pour évaluer plusieurs des LLM les plus populaires, dont beaucoup avaient récemment été mis à jour. Ils ont constaté que les créateurs de LLM n’avaient pas fait beaucoup de progrès en matière d’amélioration de la précision. La plupart n’étaient pas plus précis que leurs versions précédentes.

L’équipe a également découvert que la plupart des modèles obtenaient de meilleurs résultats lorsqu’ils pouvaient extraire des informations d’une ou plusieurs pages Wiki. Les LLM obtenaient également de meilleurs résultats avec certains sujets par rapport à d’autres. Ils avaient par exemple du mal à trouver des informations fiables sur les célébrités et les questions financières. Ils étaient plus fiables lorsqu’on leur posait certains types de questions scientifiques.

Plus d’informations :

Wenting Zhao et al, WildHallucinations : évaluation de la factualité des formes longues dans les LLM avec des requêtes d’entités du monde réel, arXiv (2024). DOI : 10.48550/arxiv.2407.17468. arxiv.org/abs/2407.17468

arXiv

© 2024 Réseau Science X

Citation:Un nouvel outil d’analyse comparative évalue la factualité des LLM (2024, 21 août) récupéré le 21 août 2024 à partir de

Ce document est soumis au droit d’auteur. En dehors de toute utilisation équitable à des fins d’étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni à titre d’information uniquement.