L’activité cérébrale associée à des mots spécifiques se reflète entre l’orateur et l’auditeur au cours d’une conversation, selon les données

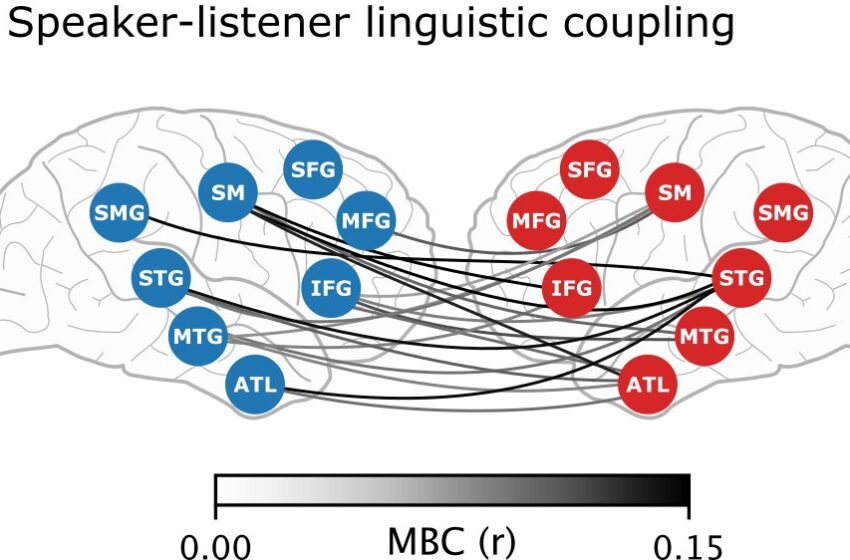

Couplage entre le cerveau du locuteur et celui de l’auditeur. Crédit : Neurone / Zada et al.

Lorsque deux personnes interagissent, leur activité cérébrale se synchronise, mais on ne savait pas jusqu’à présent dans quelle mesure ce « couplage cerveau-cerveau » était dû à des informations linguistiques ou à d’autres facteurs, comme le langage corporel ou le ton de la voix.

Les chercheurs rapportent le 2 août dans la revue Neurone que le couplage cerveau-cerveau au cours d’une conversation peut être modélisé en considérant les mots utilisés au cours de cette conversation et le contexte dans lequel ils sont utilisés.

« Nous pouvons voir le contenu linguistique émerger mot par mot dans le cerveau de l’orateur avant qu’il n’articule réellement ce qu’il essaie de dire, et le même contenu linguistique réapparaît rapidement dans le cerveau de l’auditeur après l’avoir entendu », explique le premier auteur et neuroscientifique Zaid Zada de l’Université de Princeton.

Pour communiquer verbalement, il faut s’entendre sur les définitions de différents mots, mais ces définitions peuvent changer selon le contexte. Par exemple, sans contexte, il serait impossible de savoir si le mot « froid » fait référence à la température, à un trait de personnalité ou à une infection respiratoire.

« Le sens contextuel des mots tels qu’ils apparaissent dans une phrase particulière ou dans une conversation particulière est vraiment important pour la façon dont nous nous comprenons », explique le neuroscientifique et co-auteur principal Samuel Nastase de l’Université de Princeton.

« Nous voulions tester l’importance du contexte dans l’alignement de l’activité cérébrale entre l’orateur et l’auditeur pour essayer de quantifier ce qui est partagé entre les cerveaux au cours d’une conversation. »

Pour examiner le rôle du contexte dans le couplage cérébral, l’équipe a recueilli des données sur l’activité cérébrale et des transcriptions de conversations auprès de paires de patients épileptiques au cours de conversations naturelles.

Les patients ont été soumis à une surveillance intracrânienne par électrocorticographie à des fins cliniques indépendantes au Comprehensive Epilepsy Center de la faculté de médecine de l’université de New York. Comparée à des méthodes moins invasives comme l’IRMf, l’électrocorticographie enregistre l’activité cérébrale à très haute résolution car les électrodes sont placées en contact direct avec la surface du cerveau.

Ensuite, les chercheurs ont utilisé le grand modèle linguistique GPT-2 pour extraire le contexte entourant chacun des mots utilisés dans les conversations, puis ont utilisé ces informations pour former un modèle permettant de prédire comment l’activité cérébrale change à mesure que l’information circule de l’orateur à l’auditeur pendant la conversation.

Grâce à ce modèle, les chercheurs ont pu observer l’activité cérébrale associée à la signification contextuelle des mots dans le cerveau de l’orateur et de l’auditeur.

Ils ont montré que l’activité cérébrale spécifique à un mot atteignait un pic dans le cerveau de l’orateur environ 250 ms avant qu’il ne prononce chaque mot, et que les pics correspondants de l’activité cérébrale associés aux mêmes mots apparaissaient dans le cerveau de l’auditeur environ 250 ms après les avoir entendus.

Par rapport aux travaux précédents sur le couplage cérébral entre locuteur et auditeur, le modèle d’approche basé sur le contexte de l’équipe était mieux à même de prédire les modèles partagés dans l’activité cérébrale.

« Cela montre à quel point le contexte est important, car c’est lui qui explique le mieux les données cérébrales », explique Zada. « Les grands modèles linguistiques prennent tous ces différents éléments de la linguistique, comme la syntaxe et la sémantique, et les représentent dans un seul vecteur à haute dimension. Nous montrons que ce type de modèle unifié est capable de surpasser d’autres modèles linguistiques conçus à la main. »

À l’avenir, les chercheurs prévoient d’élargir leur étude en appliquant le modèle à d’autres types de données d’activité cérébrale, par exemple des données IRMf, pour étudier comment les parties du cerveau non accessibles par électrocorticographie fonctionnent pendant les conversations.

« Il y a beaucoup de travaux passionnants à venir pour étudier comment différentes zones du cerveau se coordonnent entre elles à différentes échelles de temps et avec différents types de contenu », explique Nastase.

Plus d’information:

Un espace linguistique partagé basé sur un modèle pour transmettre nos pensées de cerveau à cerveau dans des conversations naturelles, Neurone (2024). DOI : 10.1016/j.neuron.2024.06.025. www.cell.com/neuron/fulltext/S0896-6273(24)00460-4

Citation:L’activité cérébrale associée à des mots spécifiques se reflète entre l’orateur et l’auditeur au cours d’une conversation, selon les données (2024, 2 août) récupéré le 2 août 2024 à partir de

Ce document est soumis au droit d’auteur. En dehors de toute utilisation équitable à des fins d’étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni à titre d’information uniquement.