Une nouvelle architecture de transformateur émule l’imagination et les états mentaux humains de niveau supérieur

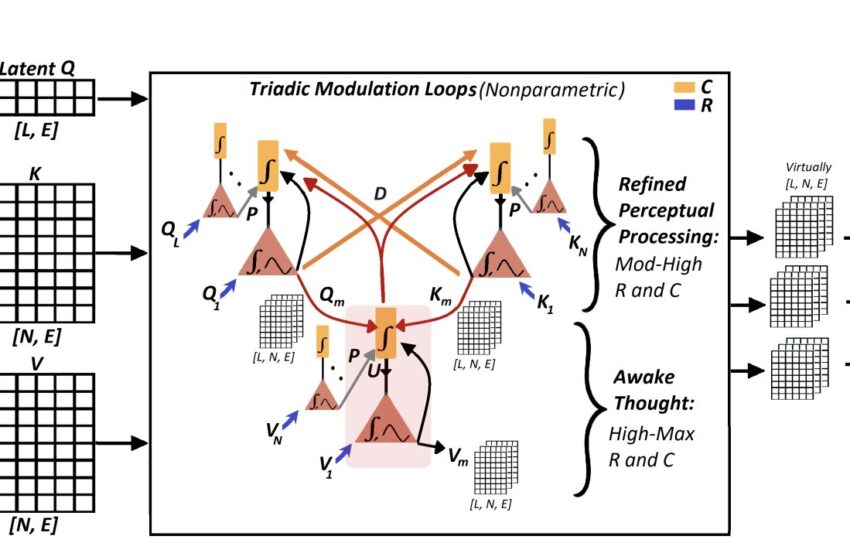

Architecture CO4: N désigne le nombre de jetons d’entrée, et chaque jeton a une dimension d’incorporation d’E. Q1, Q2, …, QL représente les jetons de requête latents dans les Q-TPN associés. K1, K2, …, KN représentent l’entrée de jetons clés des K-TPN associés. V1, v2, …, VN représente l’entrée de jetons de valeur aux V-TPN associés. Cette configuration fait partie de l’état de “Voir” (c’est-à-dire le traitement sensoriel). Dans l’état «voir comme» (c’est-à-dire, perceptuel et interprétatif), des boucles de modulation triadiques entre les questions (q), les indices (clés, k) et les hypothèses (valeurs, v) sont exécutées par des contextes distaux (d) et universels (u). Le contexte proximal (P) représente la normalisation via des informations provenant de neurones voisins dans la même population, y compris les informations antérieures du même neurone. Les TPN associés à Q, K et V sont supposés analogues à trois sous-types de neurones pyramidaux, bien que leur correspondance exacte avec des sous-types distingués neurobiologiquement soit toujours à l’étude. Grâce à des états d’esprit variables, le traitement perceptuel de haut niveau et la pensée éveillée, des chaînes de raisonnement diverses et parallèles sont activées. Ce mécanisme entraîne un coût de calcul de O (n · l), où l est une petite fraction de la longueur d’entrée, ce qui rend le coût global approximativement O (n). Les boucles de modulation triadiques, basées sur les opérations par élément, ajoutent un coût nominal de l · n · e, ce qui est nettement inférieur à celui du réseau résiduel à action directe utilisé dans les blocs de transformateur standard, un composant CO4 ne nécessite pas. Le CO4 peut être considéré comme une forme parallèle, au niveau de la représentation, silencieuse mais profonde du raisonnement de la chaîne de pensées (COT) (56) (un esprit calme), permettant une inférence multi-perspective sans nécessiter une génération de niveau séquentielle, un peu comme la modulation cortico-thalamique du cerveau. Crédit: Ahsan Adeel.

L’avancement de l’intelligence artificielle (IA) et l’étude des processus neurobiologiques sont profondément liés, car une compréhension plus profonde du premier peut donner un aperçu précieux de l’autre, et vice versa. Des études récentes de neurosciences ont montré que les transitions de l’état mental, telles que la transition de l’éveil au sommeil à ondes lents, puis au mouvement rapide des mouvements oculaires (REM), modulent les interactions temporaires dans une classe de neurones appelés neurones pyramidaux de la couche 5 (TPN), les alignant avec les états mentaux d’une personne.

Ce sont des interactions entre les informations provenant du monde externe, largement appelées champ réceptif (RF1), et des entrées émergeant des états internes, appelés champ contextuel (CF2). Les résultats antérieurs suggèrent que les entrées RF1 et CF2 sont traitées à deux sites distincts au sein des neurones, connus sous le nom de site basal et de site apical, respectivement.

Les algorithmes AI actuels utilisant des mécanismes d’attention, tels que les transformateurs, les modèles de percepteur et de flamant, sont inspirés des capacités du cerveau humain. Dans leur forme actuelle, cependant, ils n’imitent pas de manière fiable le traitement perceptuel de haut niveau et les états imaginatifs subis par les humains.

Ahsan Adeel, professeur agrégé à l’Université de Stirling, a récemment réalisé une étude explorant la possibilité de développer des modèles d’IA qui peuvent reproduire ces états mentaux plus élevés, ce qui pourrait à son tour accélérer leur apprentissage et réduire leur charge de calcul.

Son article, publié sur le arxiv serveur préalable, introduit le CO4un mécanisme de calcul cognitif sensible au contexte coopératif inspiré du cerveau spécifiquement conçu pour reproduire le mécanisme dépendant de l’état à double entrée découvert dans les TPN pyramidaux dans la couche 5 du néocortex humain.

“La participation à ce qui est pertinent est fondamental pour le cerveau des mammifères et les modèles d’apprentissage automatique modernes tels que les transformateurs”, a écrit Adeel dans son article.

“Pourtant, la détermination de la pertinence reste un défi de base, traditionnellement déchargé vers des algorithmes d’apprentissage comme la contrepropagation. Inspiré par des preuves neurobiologiques cellulaires récentes reliant les cellules pyramidales néocorticales à des états mentaux distincts, ce travail montre comment les modèles (par exemple, les transformateurs) peuvent émuler des informations pertinentes de haut niveau avant d’appliquer l’attention.”

Dans le cadre de sa récente étude, Adeel a développé un nouveau modèle de transformateur qui peut imiter le raisonnement perceptuel humain et les états imaginatifs. Ce modèle fonctionne en présélectionnant les informations pertinentes et en identifiant les parties les plus saillantes avant de lui appliquer toute son attention.

Le modèle relie les idées en suivant un modèle de raisonnement particulier, qui se concentre sur la question (c’est-à-dire ce qui est posé); indices (c’est-à-dire des informations qui pourraient aider à répondre à la question); et les valeurs ou hypothèses (c’est-à-dire les réponses possibles aux questions). Ce raisonnement “Loop” émule les façons dont les humains essaient de résoudre des problèmes, en adaptant leurs processus de réflexion au fil du temps.

“Des boucles de modulation au niveau neuronal triadiques entre les questions (Q), les indices (clés, K) et les hypothèses (valeurs, v) permettent des chaînes de raisonnement diverses, profondes et parallèles au niveau de la représentation et permettent un passage rapide des biais initiaux à une compréhension raffinée”, a écrit Adeel.

“Cela conduit à un apprentissage plus rapide des ordres de grandeur avec une demande de calcul considérablement réduite (par exemple, moins de têtes, de couches et de jetons), à un coût approximatif de O (n), où n est le nombre de jetons d’entrée. Les résultats de renforcement des résultats (EG, la carracture dans une configuration visuelle de grande dimension), la vision de l’informatique et la réponse aux questions naturelles.”

Adeel a évalué son architecture transformatrice adaptée dans une série de tâches d’apprentissage, de vision par ordinateur et de traitement du langage. Les résultats de ces tests ont été très prometteurs, soulignant la promesse de son mécanisme nouvellement développé pour faire progresser les compétences de raisonnement des modèles d’IA, les rapprochant potentiellement de ceux observés chez l’homme.

“La preuve initiale présentée ici est l’une des nombreuses raisons de croire que l’émulation des fondements cellulaires des états mentaux plus élevés, allant du traitement perceptuel de haut niveau, au raisonnement imaginatif profond et délibéré, pourrait être une étape vers l’intelligence machine cognitive significative”, a conclu Adeel.

“Cette approche ouvre la porte non seulement à la mise en œuvre d’un grand nombre de modules d’IA légers et éconergétiques, mais également à déplacer ces systèmes au-delà du simple traitement de l’information vers le raisonnement contextuel, passant de l’efficacité brute à une réelle compréhension.”

Plus d’informations:

Ahsan Adeel, au-delà de l’attention: vers des machines avec des états mentaux plus élevés intrinsèques, arxiv (2025). Doi: 10.48550 / arxiv.2505.06257

arxiv

© 2025 Science X Réseau

Citation: Une nouvelle architecture de transformateur émule l’imagination et les états mentaux humains de niveau supérieur (2025, 29 mai) récupérés le 29 mai 2025 de

Ce document est soumis au droit d’auteur. Outre toute émission équitable aux fins d’études privées ou de recherche, aucune pièce ne peut être reproduite sans l’autorisation écrite. Le contenu est fourni uniquement à des fins d’information.