Les grands modèles linguistiques peuvent-ils détecter le sarcasme ?

Crédit : Pixabay/CC0 Domaine public

Les grands modèles linguistiques (LLM) sont des algorithmes avancés d'apprentissage en profondeur qui peuvent analyser des invites dans divers langages humains, générant ensuite des réponses réalistes et exhaustives. Cette classe prometteuse de modèles de traitement du langage naturel (NLP) est devenue de plus en plus populaire après la sortie de la plateforme ChatGPT d'Open AI, qui peut répondre rapidement à un large éventail de requêtes des utilisateurs et générer des textes écrits convaincants pour différentes utilisations.

À mesure que ces modèles deviennent de plus en plus répandus, il est de la plus haute importance d’évaluer leurs capacités et leurs limites. Ces évaluations peuvent en fin de compte aider à comprendre les situations dans lesquelles les LLM sont les plus ou les moins utiles, tout en identifiant les moyens par lesquels ils pourraient être améliorés.

Juliann Zhou, chercheuse à l'Université de New York, a récemment mené une étude visant à évaluer les performances de deux LLM formés à détecter le sarcasme humain, ce qui consiste à transmettre des idées en énonçant ironiquement l'exact opposé de ce que l'on essaie de dire. Ses découvertes, publiées sur le serveur de prépublication arXivl'a aidée à délimiter les fonctionnalités et les composants algorithmiques susceptibles d'améliorer les capacités de détection des sarcasmes des agents d'IA et des robots.

“Dans le domaine de l'analyse sentimentale du traitement du langage naturel, la capacité à identifier correctement le sarcasme est nécessaire pour comprendre les véritables opinions des gens”, a écrit Zhou dans son article. “Comme l'utilisation du sarcasme est souvent basée sur le contexte, des recherches antérieures ont utilisé des modèles de représentation du langage, tels que Support Vector Machine (SVM) et Long Short-Term Memory (LSTM), pour identifier le sarcasme avec des informations contextuelles. Innovations récentes dans La PNL a fourni plus de possibilités pour détecter le sarcasme.”

Crédit : Juliann Zhou.

L'analyse des sentiments est un domaine de recherche qui consiste à analyser des textes généralement publiés sur des plateformes de médias sociaux ou d'autres sites Web pour mieux comprendre ce que les gens pensent d'un sujet ou d'un produit particulier. Aujourd’hui, de nombreuses entreprises investissent dans ce domaine, car cela peut les aider à comprendre comment améliorer leurs services et répondre aux besoins de leurs clients.

Il existe désormais plusieurs modèles de PNL capables de traiter des textes et de prédire leur ton émotionnel sous-jacent, c'est-à-dire s'ils expriment des émotions positives, négatives ou neutres. De nombreuses critiques et commentaires publiés en ligne contiennent cependant de l'ironie et du sarcasme, qui pourraient inciter les modèles à les classer comme « positifs » alors qu'ils expriment en fait une émotion négative, ou vice versa.

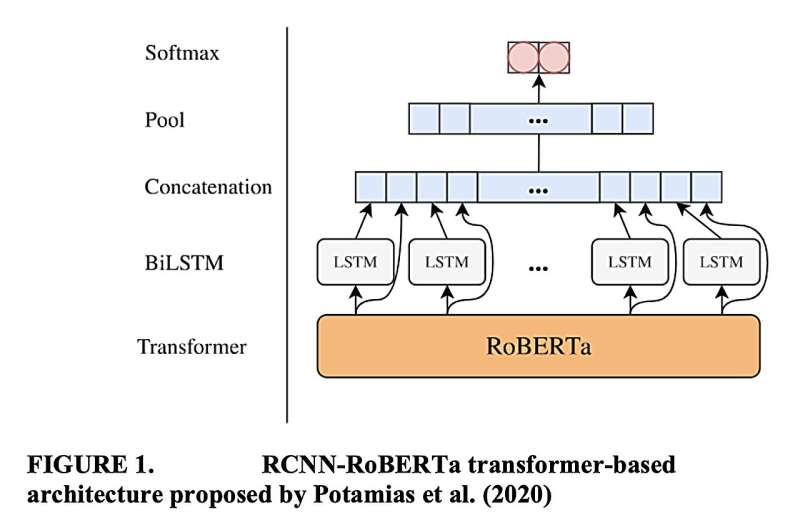

Certains informaticiens ont ainsi tenté de développer des modèles capables de détecter le sarcasme dans les textes écrits. Deux des modèles les plus prometteurs, appelés CASCADE et RCNN-RoBERTa, ont été présentés en 2018 par des groupes de recherche distincts.

“Dans BERT : Pré-entraînement de transformateurs bidirectionnels profonds pour la compréhension du langage, Jacob Devlin et al (2018) ont introduit un nouveau modèle de représentation du langage et ont démontré une plus grande précision dans l'interprétation du langage contextualisé”, a écrit Zhou. “Comme proposé par Hazarika et al (2018), CASCADE est un modèle contextuel qui produit de bons résultats pour détecter le sarcasme. Cette étude analyse un corpus Reddit à l'aide de ces deux modèles de pointe et évalue leurs performances par rapport aux modèles de base. pour trouver l'approche idéale pour détecter le sarcasme.

Essentiellement, Zhou a effectué une série de tests visant à évaluer la capacité des modèles CASCADE et RCNN-RoBERTa à détecter le sarcasme dans les commentaires publiés sur Reddit, la célèbre plateforme en ligne généralement utilisée pour évaluer le contenu et discuter de divers sujets. La capacité de ces deux modèles à détecter le sarcasme dans les exemples de textes a également été comparée à la performance humaine moyenne sur cette même tâche (rapportée dans un travail précédent) et à la performance de quelques modèles de base pour analyser des textes.

“Nous avons constaté que les informations contextuelles, telles que l'intégration de la personnalité de l'utilisateur, pourraient améliorer considérablement les performances, ainsi que l'incorporation d'un transformateur RoBERTa, par rapport à une approche CNN plus traditionnelle”, a conclu Zhou dans son article. “Compte tenu du succès des approches contextuelles et basées sur le transformateur, comme le montrent nos résultats, l'augmentation d'un transformateur avec des fonctionnalités d'informations contextuelles supplémentaires peut être une voie pour de futures expériences.”

Les résultats recueillis dans le cadre de cette étude récente pourraient bientôt guider d’autres études dans ce domaine, contribuant à terme au développement de LLM plus efficaces pour détecter le sarcasme et l’ironie dans le langage humain. Ces modèles pourraient éventuellement s’avérer être des outils extrêmement précieux pour effectuer rapidement des analyses de sentiments sur les avis, publications et autres contenus générés par les utilisateurs en ligne.

Plus d'information:

Juliann Zhou, Une évaluation des modèles de langage étendus de pointe pour la détection du sarcasme, arXiv (2023). DOI : 10.48550/arxiv.2312.03706

arXiv

© 2023 Réseau Science X

Citation: Les grands modèles de langage peuvent-ils détecter le sarcasme ? (28 décembre 2023) récupéré le 28 décembre 2023 sur

Ce document est soumis au droit d'auteur. En dehors de toute utilisation équitable à des fins d'étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni seulement pour information.