À l’aide de photos ou de vidéos, ces systèmes d’IA peuvent créer des simulations qui entraînent les robots à fonctionner dans des espaces physiques.

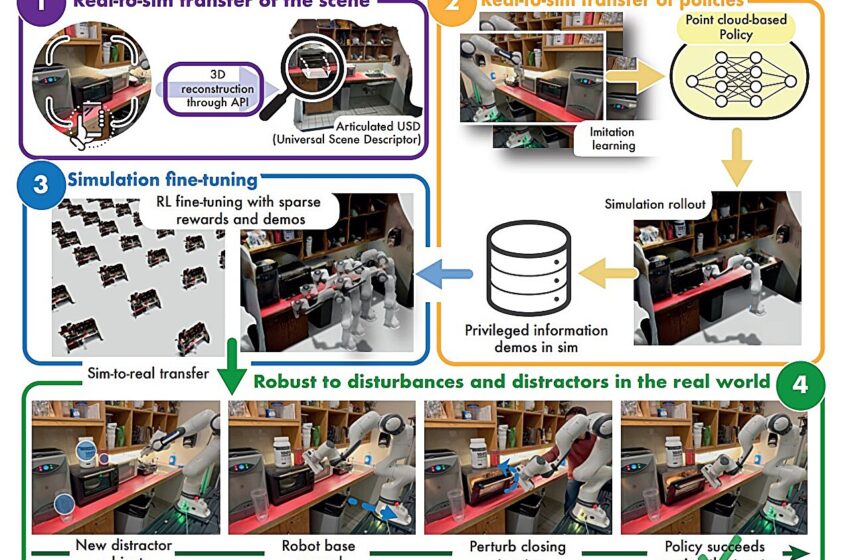

Présentation du système RialTo. 1) Transférez la scène du monde réel vers le simulateur via une API facile à utiliser (voir la section III-B). 2) Transférez une politique apprise à partir de démonstrations du monde réel pour collecter un ensemble de démonstrations avec des informations privilégiées dans la simulation. Nous notons que cette étape est facultative et que RialTo est compatible avec le fait de sauter cette étape et de fournir des démonstrations dans la simulation (voir la section IV-C2). 3) Utilisez l’ensemble de démonstrations collectées pour biaiser l’exploration dans le réglage fin RL avec des récompenses éparses d’une politique basée sur l’état (voir la section III-C). 4) Effectuez une distillation enseignant-élève et déployez la politique dans le monde réel en obtenant des comportements robustes (voir la section III-D). Crédit : Torne et al.

Les chercheurs qui travaillent sur de grands modèles d’intelligence artificielle comme ChatGPT disposent de vastes volumes de textes, de photos et de vidéos sur Internet pour entraîner les systèmes. Mais les roboticiens qui entraînent des machines physiques se heurtent à des obstacles : les données des robots sont coûteuses et, comme il n’existe pas de flottes de robots en déplacement dans le monde entier, il n’y a tout simplement pas assez de données facilement disponibles pour les faire fonctionner correctement dans des environnements dynamiques, comme les maisons des gens.

Certains chercheurs ont recours à la simulation pour entraîner les robots. Mais ce processus, qui fait souvent appel à un graphiste ou à un ingénieur, est laborieux et coûteux.

Deux nouvelles études menées par des chercheurs de l’Université de Washington présentent des systèmes d’IA qui utilisent soit des vidéos, soit des photos pour créer des simulations permettant d’entraîner des robots à fonctionner dans des conditions réelles. Cela pourrait réduire considérablement les coûts de formation des robots à fonctionner dans des environnements complexes.

Dans la première étude, un utilisateur scanne rapidement un espace avec son smartphone pour en enregistrer la géométrie. Le système, appelé RialTo, peut ensuite créer une simulation de « jumeau numérique » de l’espace, dans laquelle l’utilisateur peut saisir le fonctionnement de différents éléments (ouvrir un tiroir, par exemple).

Un robot peut alors répéter virtuellement les mouvements de la simulation avec de légères variations pour apprendre à les exécuter efficacement. Dans la deuxième étude, l’équipe a construit un système appelé URDFormer, qui prend des images d’environnements réels sur Internet et crée rapidement des environnements de simulation physiquement réalistes dans lesquels les robots peuvent s’entraîner.

Les équipes ont présenté leurs études – la première le 16 juillet et la seconde le 19 juillet – lors de la conférence Robotics Science and Systems à Delft, aux Pays-Bas.

« Nous essayons de mettre au point des systèmes qui passent à moindre coût du monde réel à la simulation », a déclaré Abhishek Gupta, professeur adjoint à l’UW à la Paul G. Allen School of Computer Science & Engineering et co-auteur principal des deux articles.

« Les systèmes peuvent ensuite entraîner les robots dans ces scènes de simulation, afin que le robot puisse fonctionner plus efficacement dans un espace physique. C’est utile pour la sécurité : on ne peut pas avoir de robots mal entraînés qui cassent des objets et blessent des gens, et cela élargit potentiellement l’accès. Si vous pouvez faire fonctionner un robot dans votre maison simplement en le scannant avec votre téléphone, cela démocratise la technologie. »

Bien que de nombreux robots soient actuellement bien adaptés au travail dans des environnements tels que les chaînes de montage, leur apprendre à interagir avec les personnes et dans des environnements moins structurés reste un défi.

« Dans une usine, par exemple, il y a énormément de répétitions », explique Zoey Chen, auteure principale de l’étude URDFormer et doctorante à l’UW à l’Allen School. « Les tâches peuvent être difficiles à réaliser, mais une fois que vous avez programmé un robot, il peut continuer à effectuer la tâche encore et encore. Alors que les maisons sont uniques et en constante évolution. Il existe une diversité d’objets, de tâches, de plans d’étage et de personnes qui s’y déplacent. C’est là que l’IA devient vraiment utile aux roboticiens. »

Les deux systèmes abordent ces défis de manière différente.

RialTo, créé par Gupta avec une équipe du Massachusetts Institute of Technology, demande à un individu de traverser un environnement et de filmer sa géométrie et ses pièces mobiles. Par exemple, dans une cuisine, il ouvrira les placards, le grille-pain et le réfrigérateur.

Le système utilise ensuite des modèles d’IA existants – et un humain effectue un travail rapide via une interface utilisateur graphique pour montrer comment les objets se déplacent – pour créer une version simulée de la cuisine présentée dans la vidéo. Un robot virtuel s’entraîne par essais et erreurs dans l’environnement simulé en essayant à plusieurs reprises d’effectuer des tâches telles que l’ouverture du four grille-pain – une méthode appelée apprentissage par renforcement.

En appliquant ce processus dans la simulation, le robot s’améliore dans cette tâche et contourne les perturbations ou les changements dans l’environnement, comme une tasse placée à côté du grille-pain. Le robot peut ensuite transférer cet apprentissage à l’environnement physique, où il est presque aussi précis qu’un robot entraîné dans une vraie cuisine.

L’autre système, URDFormer, se concentre moins sur la précision relative dans une seule cuisine ; il génère plutôt rapidement et à moindre coût des centaines de simulations de cuisine génériques. URDFormer scanne des images provenant d’Internet et les associe à des modèles existants sur la manière dont, par exemple, les tiroirs et les armoires de cuisine vont probablement se déplacer.

Il prédit ensuite une simulation à partir de l’image initiale du monde réel, ce qui permet aux chercheurs de former rapidement et à moindre coût des robots dans une vaste gamme d’environnements. Le compromis est que ces simulations sont nettement moins précises que celles générées par RialTo.

« Les deux approches peuvent se compléter », a déclaré Gupta. « URDFormer est vraiment utile pour la pré-formation sur des centaines de scénarios. RialTo est particulièrement utile si vous avez déjà pré-formé un robot et que vous souhaitez maintenant le déployer chez quelqu’un et qu’il réussisse à peu près à 95 %. »

À l’avenir, l’équipe RialTo souhaite déployer son système dans les foyers (il a été largement testé en laboratoire), et Gupta a déclaré qu’il souhaitait incorporer de petites quantités de données de formation du monde réel avec les systèmes pour améliorer leurs taux de réussite.

« Avec un peu de chance, une petite quantité de données réelles suffira à résoudre les problèmes », a déclaré M. Gupta. « Mais nous devons encore trouver la meilleure façon de combiner les données collectées directement dans le monde réel, ce qui est coûteux, avec les données collectées dans le cadre de simulations, ce qui est peu coûteux, mais légèrement erroné. »

Parmi les co-auteurs de l’article d’URDFormer figurent Aaron Walsman, Marius Memmel et Alex Fang de l’UW, tous doctorants à l’Allen School ; Karthikeya Vemuri, étudiant de premier cycle à l’Allen School ; Alan Wu, étudiant en master à l’Allen School ; et Kaichun Mo, chercheur scientifique chez NVIDIA. Dieter Fox, professeur à l’Allen School, était co-auteur principal.

Parmi les co-auteurs de l’article d’URDFormer figurent Marcel Torne, Anthony Simeonov et Tao Chen du MIT, tous doctorants ; Zechu Li, assistant de recherche ; et April Chan, étudiante de premier cycle. Pulkit Agrawal, professeur adjoint au MIT, était co-auteur principal. La recherche d’URDFormer a été partiellement financée par Amazon Science Hub.

Plus d’information:

Torne et al. Réconcilier la réalité grâce à la simulation : une approche du réel au réel pour une manipulation robuste, enriquecoronadozu.github.io/rs … s2024/rss20/p015.pdf

Chen et al. URDFormer : Un pipeline pour la construction d’environnements de simulation articulés à partir d’images du monde réel, enriquecoronadozu.github.io/rs … s2024/rss20/p124.pdf

Fourni par l’Université de Washington

Citation:À l’aide de photos ou de vidéos, ces systèmes d’IA peuvent créer des simulations qui entraînent les robots à fonctionner dans des espaces physiques (2024, 7 août) récupéré le 7 août 2024 à partir de

Ce document est soumis au droit d’auteur. En dehors de toute utilisation équitable à des fins d’étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni à titre d’information uniquement.